Un estudio reciente del Infosys Knowledge Institute revela que apenas el 2% de las empresas encuestadas cumple con los estándares de Inteligencia Artificial Responsable (RAI, por sus siglas en inglés), lo que pone en evidencia una brecha crítica en el desarrollo ético, seguro y transparente de sistemas de IA.

La investigación se basó en una encuesta a 1.500 ejecutivos de empresas con ingresos superiores a los mil millones de dólares, distribuidas en siete países y 14 industrias.

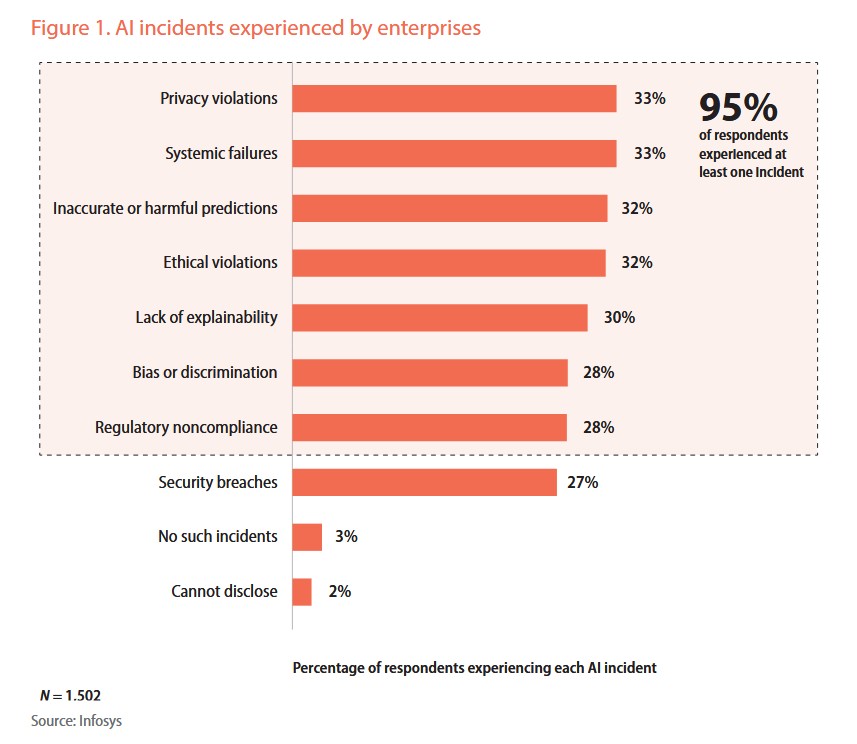

El informe señala que el 95% de las empresas ya ha enfrentado incidentes relacionados con la IA, ya sea en términos ambientales, de seguridad o de ética.

Esta cifra alarmante sugiere que la implementación de sistemas de IA sin una gobernanza adecuada está generando consecuencias tangibles.

Además, solo 38% de las compañías está tomando medidas para reducir la huella ambiental de sus modelos de IA, lo que incluye prácticas como el seguimiento de emisiones, el uso de despliegues energéticamente eficientes y la adopción de nubes sostenibles.

También te puede interesar | Disclosure Dividend: cómo la divulgación climática puede transformar los resultados financieros de las empresas

Riesgos por falta de integración ESG

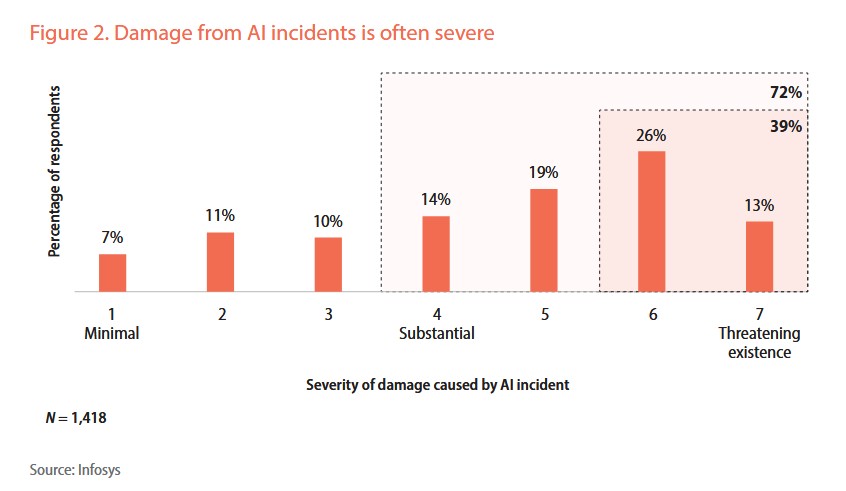

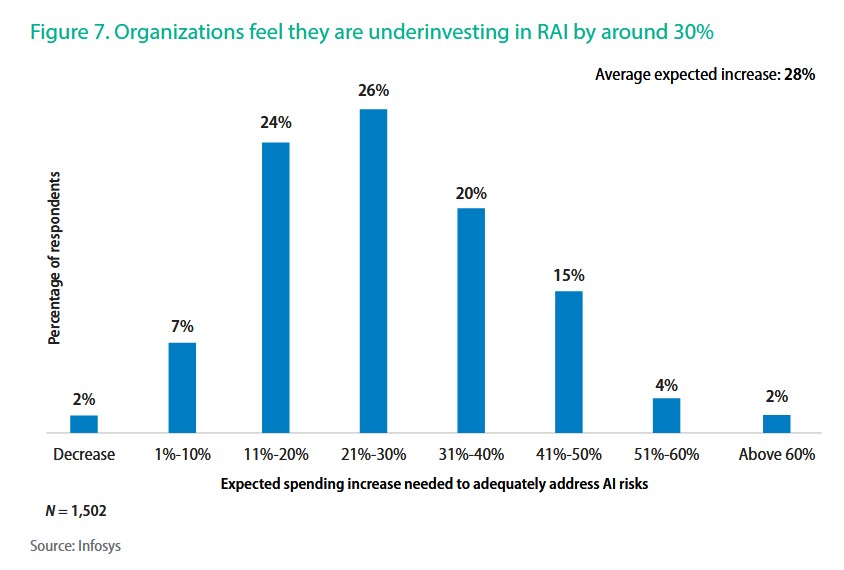

La falta de integración de los estándares RAI en las estrategias de gobernanza ambiental, social y corporativa (ESG) representa un punto ciego significativo, y el estudio advierte que esta omisión puede derivar en riesgos financieros y reputacionales graves.

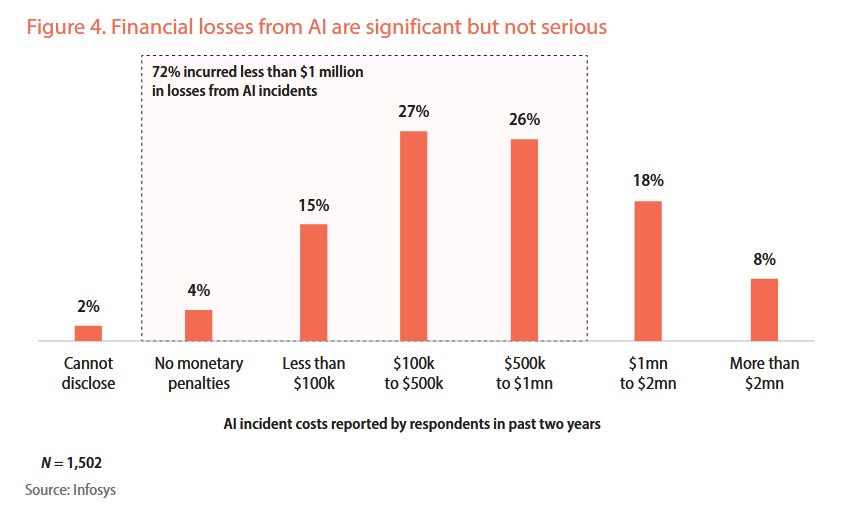

De hecho, el 77% de las empresas reportó pérdidas económicas derivadas de implementaciones deficientes de IA, mientras que el 86% de los ejecutivos anticipa nuevos desafíos regulatorios vinculados a sistemas avanzados y autónomos.

A pesar del panorama general, las empresas que han invertido en liderazgo en IA responsable están cosechando beneficios concretos.

Según el estudio, estas organizaciones enfrentan 39% menos de costos por incidentes y una menor severidad en los riesgos asociados.

Los autores del informe sostienen que los estándares RAI no deben verse únicamente como una exigencia normativa, sino como una palanca para el crecimiento y la resiliencia empresarial.

AI Act: la UE marca el camino

La Unión Europea se ha convertido en la primera jurisdicción en implementar un marco legal integral para la inteligencia artificial.

El AI Act, considerado por la Comisión Europea como la primera ley de IA del mundo, busca garantizar que los sistemas sean confiables, centrados en el ser humano y alineados con valores europeos como la seguridad, la democracia y los derechos fundamentales.

La implementación comenzó en agosto de 2024, con una primera fase de cumplimiento en febrero de 2025 que prohíbe aplicaciones como el rastreo indiscriminado de imágenes faciales desde internet o cámaras de seguridad.

El 2 de agosto de 2025, el alcance del Acta se amplió para incluir modelos de IA de propósito general que presentan riesgos sistémicos, como los desarrollados por OpenAI, Google, Meta y Anthropic.

Los nuevos proveedores deben cumplir de inmediato, mientras que los existentes tienen plazo hasta agosto de 2027.

La sostenibilidad ambiental, aún en segundo plano

Las sanciones previstas por el AI Act son contundentes: las infracciones relacionadas con usos prohibidos pueden acarrear multas de hasta €35 millones o el 7% del volumen de negocios global.

En el caso de modelos de propósito general, las multas pueden alcanzar los 15 millones de euros o el 3% del volumen de negocios.

Google ha manifestado su apoyo al código de prácticas voluntario propuesto por la UE, aunque persisten preocupaciones sobre el posible impacto en la competitividad europea en el desarrollo de IA.

Además, y a pesar de los avances regulatorios, los expertos advierten que el AI Act no otorga suficiente prioridad a la sostenibilidad ambiental, ya que el entrenamiento y despliegue de modelos de gran escala requiere enormes cantidades de energía, pero las disposiciones ecológicas siguen siendo secundarias en el marco actual.

Investigaciones recientes de BloombergNEF proyectan que la demanda energética de los centros de datos se duplicará para 2050, representando cerca del 9% del consumo energético global.

Dicho dato subraya la urgencia de incorporar criterios ambientales más robustos en la regulación de IA, especialmente ante el crecimiento exponencial de modelos generativos y sistemas autónomos.